Ontologie en IA. Ontologie en philosophie.

Temps de lecture : environ 30 minutes

Cet article propose une clarification conceptuelle rigoureuse d'un terme omniprésent dans les discours sur l'IA, mais trop souvent vidé de sa substance : l'ontologie. Son ambition : retracer la filiation philosophique d'un concept emprunté à Aristote et Quine, révéler le malentendu industriel qui confond ontologie et modèle de données, et démontrer pourquoi ces choix ontologiques conditionnent l'interopérabilité, l'explicabilité et la pérennité des investissements IA.

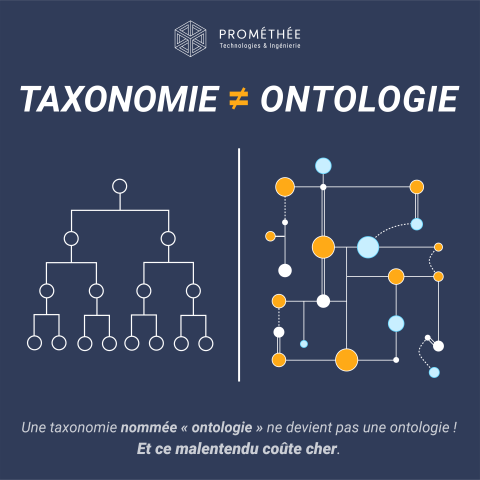

Car, loin des taxonomies élégantes rebaptisées à la hâte, l'ontologie demeure ce qu'elle a toujours été : une formalisation des hypothèses sur ce qui existe, une infrastructure invisible qui détermine ce qu'un système peut comprendre, inférer et expliquer.

« Avant d'optimiser les algorithmes, encore faut-il savoir ce qui existe. »

⏱️ L'essentiel en 30 secondes

- En philosophie, l'ontologie interroge l'être en tant qu'être ; en IA, elle formalise le sens des concepts d'un domaine de connaissance

- Un modèle de données décrit comment stocker ; une ontologie décrit ce que cela signifie et permet le raisonnement automatisé

- Quine : "être, c'est être la valeur d'une variable" ; tout système formel s'engage ontologiquement sur ce qu'il reconnaît comme existant

- Modéliser la "performance énergétique" comme propriété figée ou comme processus dynamique : ce choix ontologique détermine ce que l'IA peut comprendre et corriger

- Le malentendu coûte cher : systèmes non interopérables, décisions inexplicables, investissements IA non pérennes

- La vraie question : quels engagements ontologiques implicites portent vos modèles, et qui décide de ce que le système reconnaît comme réel ?

Le mot ontologie circule abondamment dans les discours sur l'IA, les graphes de connaissances et la gouvernance des données. Pourtant, le terme est souvent vidé de sa substance, réduit à un simple synonyme élégant de "modèle de données structuré" ou de "taxonomie enrichie".

En IA et en ingénierie des données, une ontologie est définie comme une représentation formelle, explicite et partagée d'un domaine de connaissance. Formelle, car elle repose sur des logiques décidables. Explicite, car le sens est déclaré par des axiomes, non laissé implicite. Partagée, car elle fonde un langage commun entre humains et machines, garantissant l'interopérabilité sémantique.

Cette définition, formulée par Thomas GRUBER en 1993, est devenue canonique dans la communauté de l'ingénierie des connaissances. Mais elle n'a de valeur que si l'on comprend ce qu'elle hérite de deux millénaires de philosophie, et si l'on saisit les choix techniques et les compromis qu'elle implique.

Cet article propose un parcours en trois temps : d'abord, retracer la filiation philosophique du concept d'ontologie, d'Aristote à QUINE ; ensuite, examiner les formalismes techniques qui permettent de construire des ontologies computationnelles, avec leurs forces et leurs limites ; enfin, démonter le malentendu industriel qui confond ontologie et taxonomie, et montrer pourquoi cette confusion a des conséquences majeures sur l'interopérabilité, l'explicabilité et la pérennité des systèmes IA.

En philosophie, l'ontologie interroge l'être en tant qu'être (τὸ ὂν ᾗ ὄν, en grec ancien). Cette formule aristotélicienne, issue de la Métaphysique, désigne l'étude de l'être considéré uniquement sous l'aspect de son existence, indépendamment de ses déterminations particulières. Il ne s'agit pas de décrire comment le monde se présente à nous, mais de déterminer ce qui existe réellement, sous quelle forme, selon quelles catégories fondamentales.

Dans le Livre Delta de la Métaphysique, Aristote distingue dix catégories : substance (ousia), quantité, qualité, relation, lieu, temps, position, possession, action, passion. Ces catégories ne sont pas de simples étiquettes classificatoires. Elles structurent ce qui peut être dit de l'être : toute prédication vraie sur une entité relève nécessairement de l'une de ces catégories. La substance est la catégorie première, celle qui existe en soi ; les autres catégories existent en ou par rapport à une substance.

Cette distinction est fondamentale pour comprendre ce qu'est une ontologie : catégoriser, ce n'est pas seulement ranger, c'est déterminer les modes d'existence. Une machine existe-t-elle comme substance individuelle ou comme agrégat de composants ? Une performance énergétique est-elle une qualité intrinsèque ou une relation entre paramètres ? Ces questions ne sont pas de simples choix de modélisation : elles engagent une position sur la structure du réel.

Au XXe siècle, Willard Van Orman QUINE reformule radicalement la question ontologique dans son article fondateur On What There Is (1948). Pour QUINE, la question "qu'est-ce qui existe ?" ne peut être résolue indépendamment d'un langage formel. Son célèbre critère d'engagement ontologique stipule :

Autrement dit, un système formel (qu'il s'agisse d'une théorie scientifique, d'un modèle logique ou d'une base de connaissances) s'engage ontologiquement envers toutes les entités qui doivent figurer dans le domaine de quantification de ses variables pour que ses énoncés soient vrais. Si nous affirmons "il existe des nombres premiers supérieurs à un million", nous sommes ontologiquement engagés envers l'existence des nombres.

Ce critère a une conséquence majeure : toute formalisation comporte des engagements ontologiques implicites ou explicites. On ne peut pas construire un modèle "neutre" ontologiquement. Chaque choix de représentation (définir une classe, établir une relation, poser un axiome) présuppose que certaines entités existent et que d'autres n'existent pas, ou existent autrement.

C'est précisément ce lien que l'IA computationnelle a redécouvert, souvent sans en mesurer toute la portée philosophique.

Un débat philosophique traverse toute l'histoire de l'ontologie : les universaux existent-ils réellement, ou ne sont-ils que des noms (d'où le terme nominalisme) que nous appliquons à des collections d'individus ?

Le réalisme ontologique (défendu notamment par Platon, puis sous d'autres formes par Aristote, Duns SCOT, et dans la philosophie contemporaine par David ARMSTRONG) soutient que les universaux (les propriétés, les relations, les types) ont une existence réelle, distincte des particuliers qui les instancient. Il y a quelque chose de réel qui est partagé par toutes les machines, et que nous appelons "la classe Machine".

Le nominalisme (défendu par Guillaume d'OCKHAM, puis par Nelson GOODMAN et QUINE sous des formes modernes) refuse cette multiplication d'entités : seuls les individus concrets existent, et les classes ne sont que des étiquettes linguistiques commodes, sans contrepartie ontologique réelle.

Ce débat n'est pas qu'une querelle scolastique. Il a des conséquences directes en ingénierie des ontologies : faut-il traiter les classes comme des entités à part entière (réalisme) ou comme de simples prédicats sur des individus (nominalisme) ? Les choix de formalisme (OWL Full vs OWL DL, par exemple) reflètent implicitement des positions dans ce débat philosophique.

Lorsque l'IA s'est emparée du terme "ontologie" dans les années 1990, ce n'était pas un effet de langage. Il s'agissait de dépasser les limites des modèles purement syntaxiques (bases de données relationnelles, schémas XML, modèles orientés objets), lesquels ne formalisaient que la structure des données, sans en expliciter le sens.

Une base de données stocke des faits. Elle ne sait pas ce qu'ils signifient. Elle ne peut pas répondre à la question : "qu'est-ce qu'une machine ?" ni inférer qu'une alerte persistante devrait déclencher une action de maintenance.

Une ontologie, au sens computationnel, formalise :

- Les concepts du domaine (classes, types d'entités)

- Les relations entre ces concepts (propriétés, rôles)

- Les axiomes et contraintes logiques (ce qui est nécessairement vrai)

- Les règles d'inférence permettant de dériver de nouvelles connaissances à partir des faits connus

La différence est radicale.

Prenons un exemple concret en supervision industrielle :

|

Approche 1 : "Modèle de données (SQL)" Table : Machines |

Approche 2 : "Ontologie (OWL, RDFS, SHACL)" Classe : Machine |

|

→ Structure technique | Pas de sémantique | Aucune inférence |

→ Représentation formelle à base sémantique | Raisonnement logique | Inférence automatique |

|

▸ Stocke les données |

▸ Raisonne sur les données |

L'un stocke. L'autre raisonne.

Note préliminaire : Cette section devient technique. Elle détaille les langages formels utilisés pour construire des ontologies computationnelles et les compromis entre expressivité (ce qu'on peut exprimer) et décidabilité (ce qu'on peut calculer automatiquement).

Toutes les "ontologies" ne se valent pas. Il existe une arborescence de formalismes, avec des compromis différents entre expressivité et décidabilité.

RDF et RDFS : les fondations

RDF (Resource Description Framework) est un modèle de données basé sur des triplets sujet-prédicat-objet :

<Machine_42> <a_pour_capteur> <Capteur_17>

RDFS (RDF Schema) ajoute une couche sémantique minimale :

- Hiérarchies de classes (rdfs:subClassOf)

- Hiérarchies de propriétés (rdfs:subPropertyOf)

- Domaines et portées (rdfs:domain, rdfs:range)

RDFS correspond à une ontologie légère (lightweight ontology), possédant une sémantique formelle. RDFS fournit une sémantique formelle minimale (classes, sous-classes, domaines, portées) ; il ne vise pas, à lui seul, la richesse axiomatique d'OWL. Dès qu'on vise des axiomes complexes, des contraintes logiques strictes et des inférences non triviales, RDFS s'avère généralement insuffisant.

OWL : Web Ontology Language

OWL (Web Ontology Language) est le standard W3C pour les ontologies web.

Note technique importante : La taxonomie W3C officielle distingue RDF (modèle de données en triplets), RDFS (schéma sémantique minimal), puis OWL (langage ontologique complet).

OWL lui-même se décline en plusieurs variantes qui ne forment pas une hiérarchie stricte mais plutôt une arborescence de compromis expressivité/décidabilité :

OWL Full :

- Expressivité maximale

- Permet de traiter les classes comme des individus (méta-modélisation)

- Problème : Indécidable. Aucun raisonneur ne peut garantir de terminer.

OWL DL (Description Logics) :

- Sous-ensemble décidable d'OWL

- Basé sur les logiques de description SHOIN(D) ou SROIQ(D)

- Permet : disjonction de classes, négation, restrictions de cardinalité, propriétés transitives/symétriques/fonctionnelles

- Compromis : Expressif mais décidable. Complexité élevée.

OWL 2 Profils (EL, QL, RL) :

- Profils optimisés pour des cas d'usage spécifiques

- OWL EL : Optimisé pour les grandes ontologies (complexité polynomiale). Utilisé en bio-informatique (Gene Ontology).

- OWL QL : Optimisé pour les requêtes sur bases de données (query rewriting).

- OWL RL : Optimisé pour les systèmes à base de règles.

SHACL : Shapes Constraint Language

SHACL complète OWL en permettant de définir des contraintes de validation sur les données RDF :

- Contraintes de cardinalité strictes

- Contraintes de valeurs (regex, intervalles)

- Contraintes de dépendance entre propriétés

Différence cruciale avec OWL : SHACL sert à valider des graphes RDF ; il ne définit pas une sémantique d'inférence comparable à OWL. C'est un langage de validation, pas un langage de raisonnement. Il complète OWL, il ne le remplace pas.

Un enjeu majeur des ontologies formelles est le compromis expressivité/décidabilité.

Théorème fondamental : Plus une logique est expressive, plus elle risque d'être indécidable ou de complexité prohibitive.

Complexité pour OWL DL :

La complexité du raisonnement en OWL 2 DL est, au pire, doublement exponentielle pour des tâches comme la satisfiabilité de concepts ou la subsomption. Les classes de complexité exactes varient selon le fragment précis de logique de description utilisé (SHOIN, SHOIQ, SROIQ, etc.) et selon le problème considéré (satisfiabilité, subsomption, inférence d'instance, etc.). Pour les résultats techniques précis, se référer au Description Logic Handbook (BAADER et al., 2003).

Conséquences pratiques :

- Les raisonneurs OWL (Pellet, HermiT, Fact++) peuvent exploser en temps de calcul sur des ontologies complexes

- Les systèmes industriels utilisent souvent des profils restreints (OWL EL, OWL QL) pour garantir des performances acceptables

- Le passage à l'échelle reste un défi majeur

Exemple concret : Une ontologie biomédicale comme SNOMED CT (> 350 000 concepts) nécessite des optimisations drastiques pour être utilisable en temps réel.

Les bases de données relationnelles fonctionnent sous hypothèse de monde clos (CWA) : ce qui n'est pas dans la base est faux.

Les ontologies OWL fonctionnent sous hypothèse de monde ouvert (OWA) : ce qui n'est pas explicitement affirmé est inconnu, pas nécessairement faux.

Exemple :

- En SQL : Si Machine_42 n'a pas de capteur dans la base → elle n'en a pas.

- En OWL : Si Machine_42 n'a pas de capteur déclaré → on ne sait pas si elle en a ou non.

Conséquence : La négation par échec (negation as failure) des bases de données ne fonctionne pas en OWL. Pour exprimer des incompatibilités ontologiques, on utilise des disjonctions de classes : Machine disjointWith Capteur affirme qu'aucune entité ne peut être simultanément une machine et un capteur. Si un individu est déclaré de type Machine, un raisonneur cohérent ne pourra pas l'inférer également de type Capteur.

Contournement pratique : Utiliser SPARQL avec des clauses FILTER NOT EXISTS ou combiner OWL avec des règles SWRL (Semantic Web Rule Language) qui peuvent intégrer du raisonnement en monde clos.

Aujourd'hui, on qualifie trop souvent d'"ontologie" un simple modèle de données enrichi :

- Un fichier JSON-LD (qui n'est qu'un format de sérialisation de RDF, pas un langage ontologique en soi) avec quelques classes et relations

- Une taxonomie hiérarchique élégante

- Un schéma UML rebaptisé avec le vocabulaire RDF

On a alors perdu l'essentiel.

Une taxonomie organise des concepts en hiérarchies via la relation est-un (is-a, rdfs:subClassOf). C'est utile, mais insuffisant.

Une ontologie va bien au-delà :

- Elle définit des relations complexes (composition, causalité, dépendance temporelle)

- Elle pose des axiomes logiques (si X alors nécessairement Y)

- Elle permet l'inférence automatique (dériver de nouveaux faits à partir des faits connus)

- Elle impose des contraintes d'intégrité (cohérence sémantique vérifiable)

Exemple concret :

Taxonomie (RDFS) :

CapteurTempérature subClassOf Capteur

CapteurPression subClassOf Capteur

→ Classification hiérarchique. Pas d'axiomes. Pas d'inférence non triviale.

Ontologie (OWL + règles) :

Capteur ⊑ Dispositif

Capteur ⊑ ∃ mesure.GrandeurPhysique

Capteur ⊓ (∃ mesure.Température) ≡ CapteurTempérature

Axiome : CapteurTempérature(c) ∧ valeur(c, v) ∧ v > Seuil_critique

→ ∃e. Événement(e) ∧ type(e, Alerte) ∧ source(e, c)

→ Définition formelle. Axiomes causaux. Inférence logique.

Nicola GUARINO, Stefano BORGO et leurs collaborateurs ont développé depuis les années 1990 une approche d'ontologie formelle (Formal Ontology) qui distingue rigoureusement différents niveaux ontologiques :

NIVEAU 1 - Ontologies de haut niveau (top-level ontologies) :

- DOLCE (Descriptive Ontology for Linguistic and Cognitive Engineering)

- BFO (Basic Formal Ontology)

- SUMO (Suggested Upper Merged Ontology)

Ces ontologies définissent les catégories les plus fondamentales : entité, processus, qualité, rôle, agent, événement, etc. Elles servent de fondation commune pour garantir l'interopérabilité entre ontologies de domaine.

NIVEAU 2 - Ontologies de domaine : Spécialisées sur un secteur (médecine, industrie, finance). Exemple : Gene Ontology en bio-informatique.

NIVEAU 3 - Ontologies d'application : Instancient les concepts de domaine pour un usage spécifique.

Distinction fondamentale de GUARINO : Ne pas confondre conceptualisation (structure abstraite du domaine) et ontologie (engagement formel envers une conceptualisation via un langage logique).

Citation de GUARINO (1998) :

[Une ontologie est une théorie logique qui donne un compte-rendu explicite et partiel d'une conceptualisation.]

Cette rigueur manque cruellement dans beaucoup de projets "ontologie" industriels, qui sautent directement à la modélisation de données sans clarifier la conceptualisation sous-jacente.

Construire une ontologie, c'est faire des choix ontologiques au sens de QUINE : décider de ce que le système reconnaît comme existant.

Exemple crucial : Faut-il modéliser la "performance énergétique" comme une propriété (attribut figé) ou comme un processus (état dynamique calculé) ?

Si c'est une propriété :

Machine_42 a_pour_performance_énergétique 0.85

→ Valeur stockée, potentiellement obsolète, déconnectée des conditions opératoires.

Si c'est un processus (ou une qualité dépendante selon DOLCE) :

Performance(p) ∧ inhère_à(p, Machine_42) ∧ dépend_de(p, ConditionsOpératoires)

∧ calculée_par(p, Fonction_Performance)

→ Valeur calculée dynamiquement, contextuelle, toujours cohérente.

Ce choix ontologique détermine directement :

- La nature du raisonnement automatisé (requête SQL vs inférence logique)

- La robustesse face à l'incertitude (valeur figée vs calcul adaptatif)

- L'explicabilité des décisions (pourquoi cette valeur maintenant ?)

- La pérennité du système (évolution des conditions = révision des données vs révision du modèle)

Une IA sans ontologie (modèles purement statistiques : réseaux de neurones profonds, modèles de régression) apprend des corrélations.

Une IA fondée sur une ontologie (systèmes hybrides neuro-symboliques, raisonnement sur graphes de connaissances) dispose d'une représentation formelle à base sémantique qui :

- Contraint l'espace des hypothèses (pas toutes les corrélations sont plausibles)

- Permet l'explicabilité (traçabilité des inférences logiques)

- Garantit la cohérence (détection d'incohérences par vérification d'axiomes)

- Facilite l'intégration de connaissances expertes

Précision épistémologique importante : L'IA ne "comprend" pas au sens cognitif humain. Elle manipule des représentations formelles du sens, ce qui lui permet de réaliser des inférences sémantiquement cohérentes et logiquement traçables, mais sans conscience ni intentionnalité. La différence entre une IA sans ontologie et une IA fondée sur une ontologie n'est pas une différence de "compréhension" au sens philosophique, mais une différence de structure formelle du raisonnement : corrélation statistique aveugle vs inférence logique contrainte par des axiomes sémantiques.

C'est sans doute le lien le plus profond entre l'ontologie philosophique et l'ontologie en IA.

Dans les deux cas, il s'agit de résister à la tentation du simple calcul. De s'interroger sur ce que l'on fait réellement exister dans nos modèles.

En philosophie : refuser de réduire l'être à l'étant, la structure fondamentale à la description phénoménale.

En IA : refuser de réduire l'intelligence artificielle à l'optimisation statistique aveugle, le sens formalisé à la corrélation non contrainte.

L'ontologie n'est pas un luxe conceptuel. C'est une infrastructure invisible qui conditionne :

A) L'interopérabilité entre systèmes hétérogènes

Des ontologies partagées permettent à des systèmes développés indépendamment de se comprendre. Exemple : deux systèmes industriels utilisant des référentiels différents peuvent s'aligner via une ontologie commune (ontology alignment).

B) La robustesse des décisions automatisées

Les axiomes ontologiques détectent les incohérences avant qu'elles ne propagent des erreurs. Exemple : si un capteur mesure simultanément une température de -50°C et une pression de vapeur saturante, l'ontologie détecte l'incohérence.

C) L'explicabilité des modèles

Les inférences ontologiques sont traçables et justifiables. Exemple : "Pourquoi la maintenance a-t-elle été déclenchée ?" → "Parce que l'axiome A1 + la règle R2 + les faits F1, F2, F3 impliquent logiquement cette action."

D) La soutenabilité des investissements IA

Une ontologie bien conçue est pérenne : on peut changer l'implémentation technique sans perdre la sémantique. Les connaissances métier sont découplées de leur représentation computationnelle.

E) L'intégration de contraintes multi-objectifs

Performance + robustesse + soutenabilité = compromis formalisables dans l'ontologie. Les conflits d'objectifs deviennent explicites et négociables.

Avant d'optimiser les algorithmes, encore faut-il savoir ce qui existe, et sous quelle forme cela existe.

Les ontologies ne sont pas une solution miracle. Elles font face à plusieurs défis majeurs :

A) Coût de construction et de maintenance

Construire une ontologie formelle rigoureuse demande du temps, de l'expertise philosophique ET technique. Les ontologies doivent évoluer avec le domaine, ce qui impose une gouvernance continue.

B) Problème de l'acquisition automatique de connaissances

Extraire automatiquement des ontologies depuis des textes ou des bases de données reste un problème ouvert. Les approches par apprentissage automatique (ontology learning) produisent des ébauches, pas des ontologies formellement valides.

C) Tension entre expressivité et performance

Les raisonneurs OWL DL peuvent avoir des temps de calcul prohibitifs sur les grandes ontologies. Les profils restreints (OWL EL, OWL QL) sacrifient de l'expressivité pour garantir des performances acceptables.

D) Intégration avec l'apprentissage profond

Les architectures neuro-symboliques (combinant réseaux de neurones et raisonnement ontologique) sont prometteuses mais encore immatures. Exemple : Knowledge Graph Embeddings (KGE) tentent de projeter les ontologies dans des espaces vectoriels continus, mais perdent une partie de la sémantique logique.

Et le pluralisme ontologique dans tout ça ?

Différentes communautés adoptent des ontologies incompatibles pour le même domaine. L'alignement d'ontologies (ontology matching) reste un problème complexe.

Ces limites ne disqualifient pas les ontologies. Elles rappellent simplement qu'aucun formalisme n'est universel, et que le choix d'une approche ontologique doit être motivé par les besoins spécifiques du domaine et les contraintes techniques du système.

Chez Prométhée T&I, nous ne construisons pas des modèles de données. Nous concevons des ontologies industrielles, inscrites dans une approche systémique et holistique des systèmes complexes.

Nous ne détaillerons pas ici pour ne pas alourdir cet article dédié à l'ontologie, mais sachez que par "approche systémique", nous entendons spécifiquement l'application des principes de la théorie générale des systèmes (VON BERTALANFFY, 1968) : - Modélisation des interdépendances et des boucles de rétroaction - Identification des propriétés émergentes non réductibles aux composants - Formalisation des comportements dynamiques sous contraintes multiples

Parce que superviser, optimiser ou décarboner un système ne consiste jamais à empiler des mesures isolées. Il s'agit de formaliser le sens des grandeurs physiques, des processus, des contraintes métier et de leurs interdépendances.

Nos ontologies articulent les lois physiques et leurs couplages multi-physiques, les processus industriels et leurs états critiques, les contraintes énergétiques, environnementales et économiques, les règles métier explicites et les savoirs tacites des opérateurs, ainsi que les interactions entre sous-systèmes techniques, humains et organisationnels.

Cette approche systémique permet à l'IA de ne pas raisonner localement, mais globalement, en tenant compte des effets croisés, des boucles de rétroaction et des compromis réels entre performance, robustesse et soutenabilité.

Le résultat n'est pas une IA qui prédit mécaniquement. C'est une IA qui dispose d'une représentation formelle du système, qui infère des conséquences logiques à partir de faits observés, qui explique ses recommandations par des chaînes de raisonnement traçables.

Ce texte est "exigeant". Volontairement. Il ne cherche ni le buzz ni la simplification abusive.

Nous avons voulu montrer que le terme "ontologie", emprunté à vingt-cinq siècles de philosophie, ne peut être réduit à un synonyme élégant de "modèle de données structuré". Une ontologie n'est pas une taxonomie. Elle n'est pas un schéma UML rebaptisé. Elle n'est pas un fichier JSON-LD avec quelques classes.

Une ontologie est un engagement formel envers une conceptualisation. Elle suppose des choix ontologiques explicites, des axiomes logiques vérifiables, des règles d'inférence formalisées. Elle permet le raisonnement automatique, la détection d'incohérences, l'explicabilité des décisions.

Ces exigences ne sont pas gratuites. Elles ont un coût en termes de complexité, de temps de développement, de compétences requises. Mais elles sont la condition sine qua non de systèmes IA interopérables, robustes, explicables et pérennes.

Si vos systèmes IA peinent à s'interfacer, à expliquer leurs décisions, ou à s'adapter aux évolutions métier, interrogez-vous sur leur fondation ontologique.

L'IA sérieuse commence avant le code, là où l'on décide ce que le système reconnaît comme existant, mesurable et intelligible.

Là où l'on choisit, consciemment et rigoureusement, les catégories de l'être qui structureront la représentation computationnelle du monde.

Références fondatrices :

GRUBER, Thomas R. (1993) A Translation Approach to Portable Ontology Specifications, Knowledge Acquisition, 5(2), p. 199-220. Article fondateur de l'ontologie en informatique et intelligence artificielle. Introduit la définition canonique : "une ontologie est une spécification formelle d'une conceptualisation partagée". Décrit le système Ontolingua qui permet de traduire des ontologies entre différents formalismes de représentation des connaissances.

Aristote (IVe siècle av. J.-C.) Métaphysique, notamment Livre Delta (Δ), traduction de Jules TRICOT, Vrin, collection Bibliothèque des textes philosophiques (éditions multiples : 1933, 1953, 1991, 2000). Œuvre fondatrice de la métaphysique occidentale. Le Livre Delta définit les dix catégories de l'être : substance, quantité, qualité, relation, lieu, temps, position, possession, action, passion. Texte de référence pour comprendre que toute ontologie, même informatique, repose sur des choix concernant les catégories fondamentales du réel.

QUINE, Willard Van Orman (1948) On What There Is, The Review of Metaphysics, 2(5), p. 21-38. Article philosophique majeur qui reformule la question ontologique. Introduit le critère d'engagement ontologique : "être, c'est être la valeur d'une variable". Tout système formel est ontologiquement engagé envers les entités dont il doit présupposer l'existence pour que ses énoncés soient vrais. Indispensable pour comprendre que toute formalisation comporte des engagements ontologiques implicites.

Ontologie formelle et ingénierie des connaissances :

GUARINO, Nicola (1998) Formal Ontology and Information Systems, in N. GUARINO (ed.), Proceedings of FOIS'98, Trento, Italy, IOS Press, p. 3-15. Distinction rigoureuse entre conceptualisation et ontologie. Définit une ontologie comme "une théorie logique qui donne un compte-rendu explicite et partiel d'une conceptualisation". Pose les fondations méthodologiques de l'ontologie formelle en IA.

GUARINO, Nicola ; OBERLE, Daniel ; STAAB, Steffen (2009) What is an Ontology?, in S. STAAB & R. STUDER (eds.), Handbook on Ontologies, 2nd edition, Springer, p. 1-17. Synthèse accessible des fondements philosophiques et techniques des ontologies computationnelles. Clarifie les malentendus entre ontologies philosophiques, ontologies formelles et modèles conceptuels.

BORGO, Stefano ; MASOLO, Claudio (2009) Foundational Choices in DOLCE, in S. STAAB & R. STUDER (eds.), Handbook on Ontologies, 2nd edition, Springer, p. 361-381. Présentation de DOLCE (Descriptive Ontology for Linguistic and Cognitive Engineering), une ontologie de haut niveau fondée sur des distinctions philosophiques rigoureuses (endurants vs perdurants, qualités vs rôles, etc.).

Standards et formalismes :

W3C OWL Working Group (2012) OWL 2 Web Ontology Language Document Overview (Second Edition), W3C Recommendation, 11 December 2012. Spécification officielle du langage OWL 2, avec ses différents profils (OWL DL, OWL EL, OWL QL, OWL RL). Référence technique incontournable.

W3C (2017) Shapes Constraint Language (SHACL), W3C Recommendation, 20 July 2017. Spécification du langage SHACL pour la validation de graphes RDF. Complète OWL en permettant des contraintes de validation strictes.

HITZLER, Pascal ; KRÖTZSCH, Markus ; RUDOLPH, Sebastian (2009) Foundations of Semantic Web Technologies, Chapman & Hall/CRC. Manuel de référence sur les fondements logiques du web sémantique (RDF, RDFS, OWL, SPARQL). Traite en profondeur les logiques de description et leur complexité computationnelle.

Complexité et limites :

BAADER, Franz ; CALVANESE, Diego ; McGUINNESS, Deborah ; NARDI, Daniele ; PATEL-SCHNEIDER, Peter (eds.) (2003) The Description Logic Handbook: Theory, Implementation, and Applications, Cambridge University Press. Référence académique sur les logiques de description. Couvre la théorie (complexité, décidabilité), les algorithmes de raisonnement, et les applications pratiques.

Théorie des systèmes :

VON BERTALANFFY, Ludwig (1968) General System Theory: Foundations, Development, Applications*, George Braziller, New York. Ouvrage fondateur de la théorie générale des systèmes. Introduit les concepts d'interdépendance, d'émergence, de rétroaction et de comportement dynamique des systèmes complexes. Référence incontournable pour toute approche systémique rigoureuse.

Applications industrielles :

KIFER, Michael ; DE BRUIJN, Jos ; BOLEY, Harold ; FENSEL, Dieter (2005) A Realistic Architecture for the Semantic Web, in Proceedings of RuleML 2005, LNCS 3791, Springer, p. 17-29. Propose une architecture réaliste intégrant ontologies OWL et règles métier. Discute les compromis expressivité / efficacité pour les systèmes industriels.